W poście opisałem ogólne podejście to radzenia sobie z bardzo głęboką rekursją, która prowadzi do StackOverflowException. Dzisiaj powrócę do tematu. Od czasu do czasu, oprócz pogłębiania wiedzy na temat bibliotek, framework'ów itd. lubię rozwiązywać różnego rodzaju algorytmiczne zadania programistyczne. Jakiś czas temu rozwiązywałem takie zadanie:

Zadana jest mapa świata w postaci prostokątnej tablicy dwuwymiarowej. Każdy element tablicy ma swój kolor. Sąsiadujące (stykające się jednym z boków) z sobą elementy tego samego koloru należą do jednego kraju. Należy policzyć liczbę krajów na tej mapie. Jeśli dwa elementy tablicy mają ten sam kolor, ale nie znajdują się w jednym ciągłym obszarze, to należą do różnych krajów.

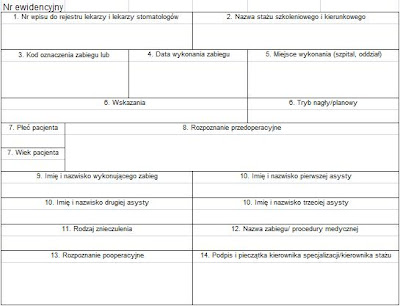

Poniższy rysunek przedstawia przykładową mapę takiego świata, na który składa się 6 krajów.

Zacznijmy od głównej metody wykonującej obliczenia. Koncepcja jest prosta. Nie ulega wątpliwości, że należy odwiedzić wszystkie elementy tablicy aby móc zwrócić poprawny wynik. Aby nie zliczać tego samego elementu dwa razy używam wartości Int32.MaxValue jako znacznika już odwiedzonych elementów. Jeśli odwiedzając kolejny element znajduję wartość inną niż Int32.MaxValue to znaczy, że danego elementu jeszcze nie odwiedziłem i zwiększam licznik krajów.

Co kryje się pod tajemniczym Zaznacz elementy należące do danego kraju? W pierwszym podejście napisałem funkcję rekurencyjną, która począwszy od zadanego elementu odwiedzała wszystkie pola należącego do danego kraju i oznaczała je jako odwiedzone.

Poniżej kod testujący dla przykładu z początku postu:

W warunkach zadania było jednak napisane, że szerokość/wysokość mapy może znajdować się w przedziale od 1 do 1000000. Sprawdźmy, więc czy kod ten obsłuż dużo większą mapę:

Na mojej maszynie wystarczy już mapa 10000 x 10000 aby pojawił sie wyjątek StackOverflowException. Zgodnie z tym co napisałem we wcześniejszym poście metoda VisitCountry powinna więc wyglądać tak:

Tym razem mapa 10000 x 10000 i większe zostanie poprawnie obsłużona. Kod ten można jeszcze optymalizować. Na przykład zliczać ile pól się już odwiedziło i przerwać dalsze przetwarzanie, jeśli odwiedziło się wszystkie. Dalszą optymalizację kodu można potraktować jako ćwiczenie.

Zadana jest mapa świata w postaci prostokątnej tablicy dwuwymiarowej. Każdy element tablicy ma swój kolor. Sąsiadujące (stykające się jednym z boków) z sobą elementy tego samego koloru należą do jednego kraju. Należy policzyć liczbę krajów na tej mapie. Jeśli dwa elementy tablicy mają ten sam kolor, ale nie znajdują się w jednym ciągłym obszarze, to należą do różnych krajów.

Poniższy rysunek przedstawia przykładową mapę takiego świata, na który składa się 6 krajów.

Zacznijmy od głównej metody wykonującej obliczenia. Koncepcja jest prosta. Nie ulega wątpliwości, że należy odwiedzić wszystkie elementy tablicy aby móc zwrócić poprawny wynik. Aby nie zliczać tego samego elementu dwa razy używam wartości Int32.MaxValue jako znacznika już odwiedzonych elementów. Jeśli odwiedzając kolejny element znajduję wartość inną niż Int32.MaxValue to znaczy, że danego elementu jeszcze nie odwiedziłem i zwiększam licznik krajów.

public int Count(int[][] map)

{

if (map == null) return 0;

if (map.Length == 0) return 0;

var numberOfCountries = 0;

for (var y = 0; y < map.Length; ++y)

{

for (var x = 0; x < map[0].Length; ++x)

{

if (map[y][x] != Int32.MaxValue)

{

numberOfCountries++;

/* Zaznacz elementy należące do danego kraju */

VisitCountry(map, map[y][x], y, x);

}

}

}

return numberOfCountries;

}

Co kryje się pod tajemniczym Zaznacz elementy należące do danego kraju? W pierwszym podejście napisałem funkcję rekurencyjną, która począwszy od zadanego elementu odwiedzała wszystkie pola należącego do danego kraju i oznaczała je jako odwiedzone.

public void VisitCountry(int[][] map, int currentColor, int y, int x)

{

if (y < 0 || x < 0 || y >= map.Length || x >= map[0].Length) return;

if (map[y][x] != currentColor) return;

map[y][x] = Int32.MaxValue;

VisitCountry(map, currentColor, y + 1, x);

VisitCountry(map, currentColor, y, x + 1);

VisitCountry(map, currentColor, y - 1, x);

VisitCountry(map, currentColor, y, x - 1);

}

Poniżej kod testujący dla przykładu z początku postu:

int[][] map = new int[5][]; for (int i = 0; i < map.Length; ++i) map[i] = new int[4]; map[0][0] = 1; map[0][1] = 3; map[0][2] = 3; map[0][3] = 2; map[1][0] = 1; map[1][1] = 2; map[1][2] = 3; map[1][3] = 2; map[2][0] = 1; map[2][1] = 1; map[2][2] = 1; map[2][3] = 1; map[3][0] = 2; map[3][1] = 3; map[3][2] = 3; map[3][3] = 1; map[4][0] = 2; map[4][1] = 2; map[4][2] = 2; map[4][3] = 2; var result = Count(map);

W warunkach zadania było jednak napisane, że szerokość/wysokość mapy może znajdować się w przedziale od 1 do 1000000. Sprawdźmy, więc czy kod ten obsłuż dużo większą mapę:

int[][] bigMap = new int[10000][];

for (int i = 0; i < bigMap.Length; ++i)

{

bigMap[i] = new int[10000];

for (int j = 0; j < bigMap.Length; ++j)

bigMap[i][j] = i;

}

var result = Count(bigMap);

Na mojej maszynie wystarczy już mapa 10000 x 10000 aby pojawił sie wyjątek StackOverflowException. Zgodnie z tym co napisałem we wcześniejszym poście metoda VisitCountry powinna więc wyglądać tak:

public void VisitCountry(int[][] map, int startY, int startX)

{

var toCheck = new Queue<Tuple<int, int>>();

toCheck.Enqueue(new Tuple<int, int>(startY, startX));

var currentColor = map[startY][startX];

while (toCheck.Count > 0)

{

var t = toCheck.Dequeue();

if (t.Item1 < 0 || t.Item2 < 0 || t.Item1 >= map.Length || t.Item2 >= map[0].Length) continue;

if (map[t.Item1][t.Item2] != currentColor) continue;

map[t.Item1][t.Item2] = Int32.MaxValue;

toCheck.Enqueue(new Tuple<int, int>(t.Item1 + 1, t.Item2));

toCheck.Enqueue(new Tuple<int, int>(t.Item1, t.Item2 + 1));

toCheck.Enqueue(new Tuple<int, int>(t.Item1 - 1, t.Item2));

toCheck.Enqueue(new Tuple<int, int>(t.Item1, t.Item2 - 1));

}

}

Tym razem mapa 10000 x 10000 i większe zostanie poprawnie obsłużona. Kod ten można jeszcze optymalizować. Na przykład zliczać ile pól się już odwiedziło i przerwać dalsze przetwarzanie, jeśli odwiedziło się wszystkie. Dalszą optymalizację kodu można potraktować jako ćwiczenie.

orcid.org/0000-0002-6838-2135

orcid.org/0000-0002-6838-2135